Dolby Vision VS HDR10+ VS HDR10 : quelle est la meilleure solution ?

Résumé : Le High Dynamic Range (abrégé en HDR) est une technologie vidéo qui améliore la qualité de l'image par rapport à un contenu normal. HDR10, HDR10+ et Dolby Vision sont les trois principaux formats HDR. Chacun d'entre eux affiche le contenu HDR différemment et présente des avantages et des inconvénients. L'article ci-dessous présente en détail les principales différences entre HDR10, HDR10+ et Dolby Vision. Lisez ce qui suit pour en savoir plus sur ces technologies.

Table des matières

Qu'est-ce que le HDR ?

Avant de savoir ce qu'est le HDR10 et d'autres technologies, donnons quelques informations sur le HDR. Le HDR est une fonction largement utilisée sur les téléviseurs 4K et Full HD. Les téléviseurs Full 4K et HD offrent tous deux une excellente qualité d'image par rapport aux technologies traditionnelles. Le HDR est conçu pour rendre les choses plus vivantes et améliorer la qualité de l'image.

En résumé, la technologie HDR vise à produire une image réaliste, plus proche de ce que voient les gens. Cela signifie que les gens voient une plus grande gamme de profondeur et de couleurs dans le contraste entre les tons plus sombres et plus clairs. En plus d'équilibrer le contraste et les couleurs, cette technologie combine l'ajustement et l'atténuation des niveaux de luminosité pour créer des images aux niveaux de nit les plus élevés. Les niveaux de nit correspondent à la luminosité qu'un appareil peut produire.

Qu'est-ce que le HDR10 et le HDR10+ ?

Dans cette bataille entre HDR 10 vs HDR10+ vs Dolby Vision, commençons par savoir ce que sont HDR10 et HDR10+. Ces deux normes sont les plus récentes du HDR. Le HDR 10 a été lancé par la Consumer Technology Association et le HDR10+ a été mis en place par Amazon Video et Samsung. Ces deux technologies permettent d'améliorer la qualité de l'image, mais de manière quelque peu différente. La norme HDR 10 transmet des métadonnées statiques au flux vidéo, c'est-à-dire des données cryptées relatives aux paramètres d'étalonnage des couleurs nécessaires pour donner à l'image une apparence réelle.

La norme HDR10+ fonctionne différemment de la norme HDR10. Il transmet des métadonnées dynamiques qui permettent aux téléviseurs d'ajuster la luminosité et les niveaux de couleur image par image. Cela permet à l'image de paraître réaliste. HDR10 prévoit de créer une luminosité maximale de 1000 nits, tandis que HDR10+ offre 4000 nits. En outre, les deux technologies prennent en charge une profondeur de couleur de 10 bits, soit près de 1024 nuances de couleurs primaires. Les deux normes sont les plus utilisées et sont proposées dans les téléviseurs de milieu et de haut de gamme.

Qu'est-ce que la norme Dolby Vision ?

Dans cette bataille entre HDR10 vs HDR400 vs Dolby Vision, il est temps d'en savoir plus sur Dolby Vision. Cette norme est une autre nouvelle version HDR de marque, lancée par les laboratoires Dolby. La plupart des téléviseurs OLED et 4K haut de gamme sont dotés de cette fonction, en plus du HDR10. LG a commencé à ajouter cette fonction à la plupart de ses appareils haut de gamme. Comme pour le HDR10+, Dolby Vision transmet également des métadonnées dynamiques à l'appareil.

Il prend également en charge 4096 nuances de couleurs primaires, ce qui correspond à une profondeur de couleur de 12 bits. En outre, Dolby Vision prévoit de créer une luminosité maximale de 10 000 nits. Cela signifie que les téléviseurs équipés de cette norme peuvent créer 10 fois plus de luminosité que le HDR10. Toutefois, très peu d'appareils prennent en charge une valeur de 10 000 nits. Dolby Vision est une technologie puissante qui s'implante lentement dans les appareils haut de gamme.

Différences entre HDR10, HDR10+ et Dolby Vision

Si vous comparez les formats HDR10+, HDR10 et Dolby Vision, vous devez prêter attention à certains éléments, notamment la profondeur de bits, la profondeur des couleurs, les métadonnées et les appareils pris en charge. HDR10 est le format le plus largement utilisé parmi les trois normes, et tous les appareils modernes prennent en charge HDR10. Dolby Vision vs HDR10+ est le format le plus avancé, et bien que de nombreux appareils prennent en charge soit Dolby Vision soit HDR10+, certains appareils prennent en charge les deux, de sorte qu'ils ne s'excluent pas mutuellement. Voyons en détail les différences entre ces normes.

Profondeur de bits

La profondeur de bits ou profondeur de couleur est la quantité de données que le téléviseur peut utiliser pour indiquer à un pixel la couleur à afficher. Si un appareil dispose d'une plus grande profondeur de couleur, il peut réduire l'effet de bande et afficher plus de couleurs dans les scènes comportant des nuances de mêmes couleurs. Un téléviseur 8 bits affiche 16,7 millions de couleurs, ce qui est normalement utilisé dans le contenu SDR, et une profondeur de couleur 10 bits offre 1,07 milliard de couleurs. Un téléviseur 12 bits affiche 68,7 milliards de couleurs. HDR10+ et Dolby Vision peuvent techniquement prendre en charge des vidéos avec une profondeur de couleur supérieure à 10 bits, mais ces vidéos sont limitées aux Blu-ray Ultra HD Dolby Vision.

Métadonnées

Dans cette bataille entre HDR et HDR10, les métadonnées peuvent être considérées comme un manuel d'utilisation qui décrit différents aspects du contenu. Elles accompagnent les films ou les séries et aident la télévision à traiter les vidéos de la manière la plus efficace possible.

Plates-formes prises en charge

La disponibilité des nouveaux formats HDR s'est radicalement améliorée au fil du temps. Tous les contenus HDR sont en tout cas disponibles en HDR10, et le Dolby Vision est fourni avec la plupart des plateformes de diffusion en continu. Même si son utilisation n'est pas aussi répandue, le HDR10+ gagne en popularité avec les Blu-rays et certaines plateformes de streaming comme Amazon Prime Video.

Téléviseurs pris en charge

Alors que la plupart des téléviseurs prennent en charge le HDR10 et que de nombreux appareils prennent en charge au minimum l'un des formats améliorés, seules quelques sociétés telles que Hisense, Vizio et TCL prennent en charge les deux formats sur leurs modèles. Aux États-Unis, LG et Sony prennent en charge le Dolby Vision, tandis que les téléviseurs Samsung prennent en charge le HDR10+. Les utilisateurs ne doivent pas s'attendre à ce que les téléviseurs HDR bon marché utilisent toutes les fonctions supplémentaires des formats. Pour la plupart d'entre eux, les utilisateurs ne seront même pas en mesure de voir une différence, car seuls les modèles haut de gamme peuvent tirer parti du HDR et l'exploiter au maximum de ses capacités.

HLG

HDR10+, Dolby Vision et HDR10 ne sont pas les seules normes HDR. Il existe également la norme HLG, également appelée Hybrid Log-Gamma. Tous les appareils modernes la prennent en charge, et la norme HLG prévoit de simplifier les choses en mélangeant le HDR et le SDR en un seul signal. Il est parfait pour les diffusions en direct, car tous les téléviseurs qui reçoivent le signal sont compatibles avec lui. Si le téléviseur prend en charge le HDR, il l'affichera en HDR ; dans le cas contraire, la partie SDR du signal sera affichée. Comme il est destiné aux diffusions en direct, il y a très peu de contenu HLG disponible.

Compatibilité ascendante

Les formats Dolby Vision et HDR10+ sont rétrocompatibles avec les formats HDR normaux sur les Blu-ray Ultra HD. Par conséquent, si les utilisateurs regardent des contenus plus anciens en HDR, ils n'auront pas à se préoccuper du format utilisé, car leur nouveau modèle sera en mesure de les afficher. HDR10+ et Dolby Vision sont tous deux rétrocompatibles, mais ils utilisent des technologies distinctes pour développer les formats HDR antérieurs.

HDR10+ inclut des métadonnées dynamiques dans le contenu HDR10. Par conséquent, si un appareil HDR10+ doit afficher du contenu HDR10, il le fait sans avoir besoin des métadonnées dynamiques. Dolby Vision est plus complexe car il peut utiliser n'importe quel format HDR standard comme couche de base et se développer à partir de celui-ci. Comme il se développe à partir de métadonnées statiques, les téléviseurs compatibles avec Dolby Vision peuvent lire les métadonnées standard séparément, ce qui les rend compatibles en amont.

Bonus : utilisez le lecteur PlayerFab All-In-One pour profiter du HDR10+ et du Dolby Vision.

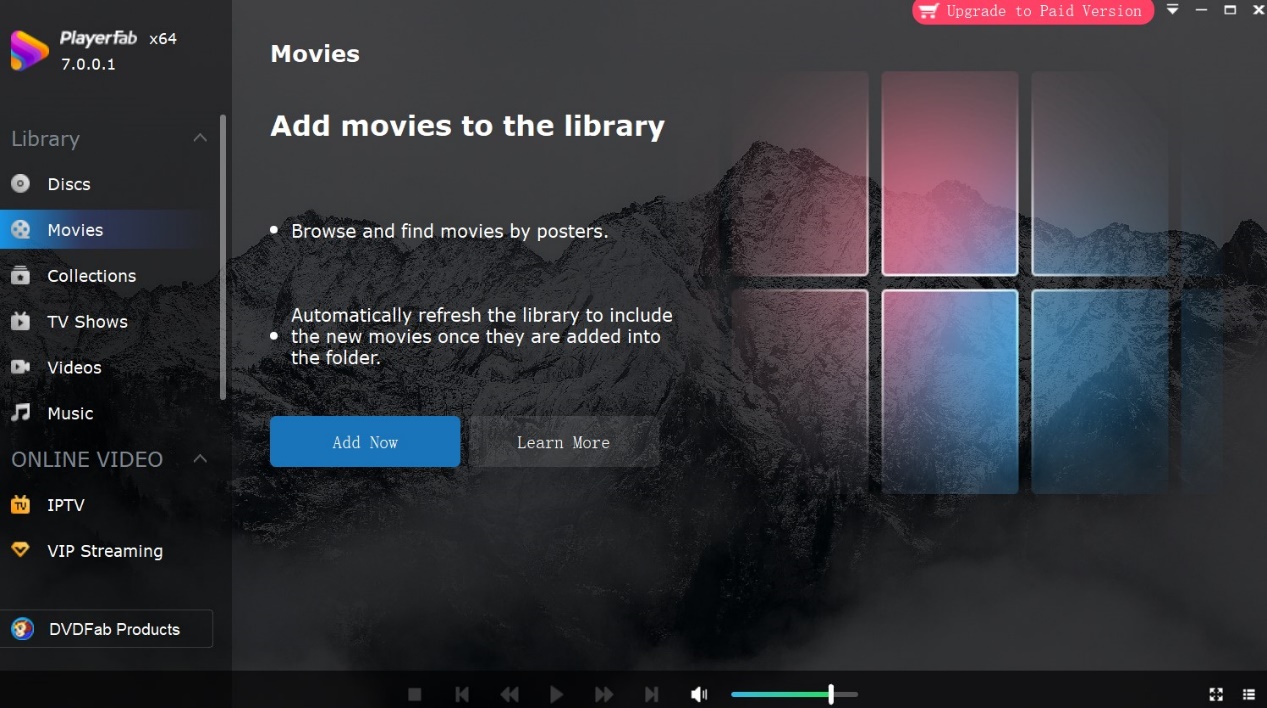

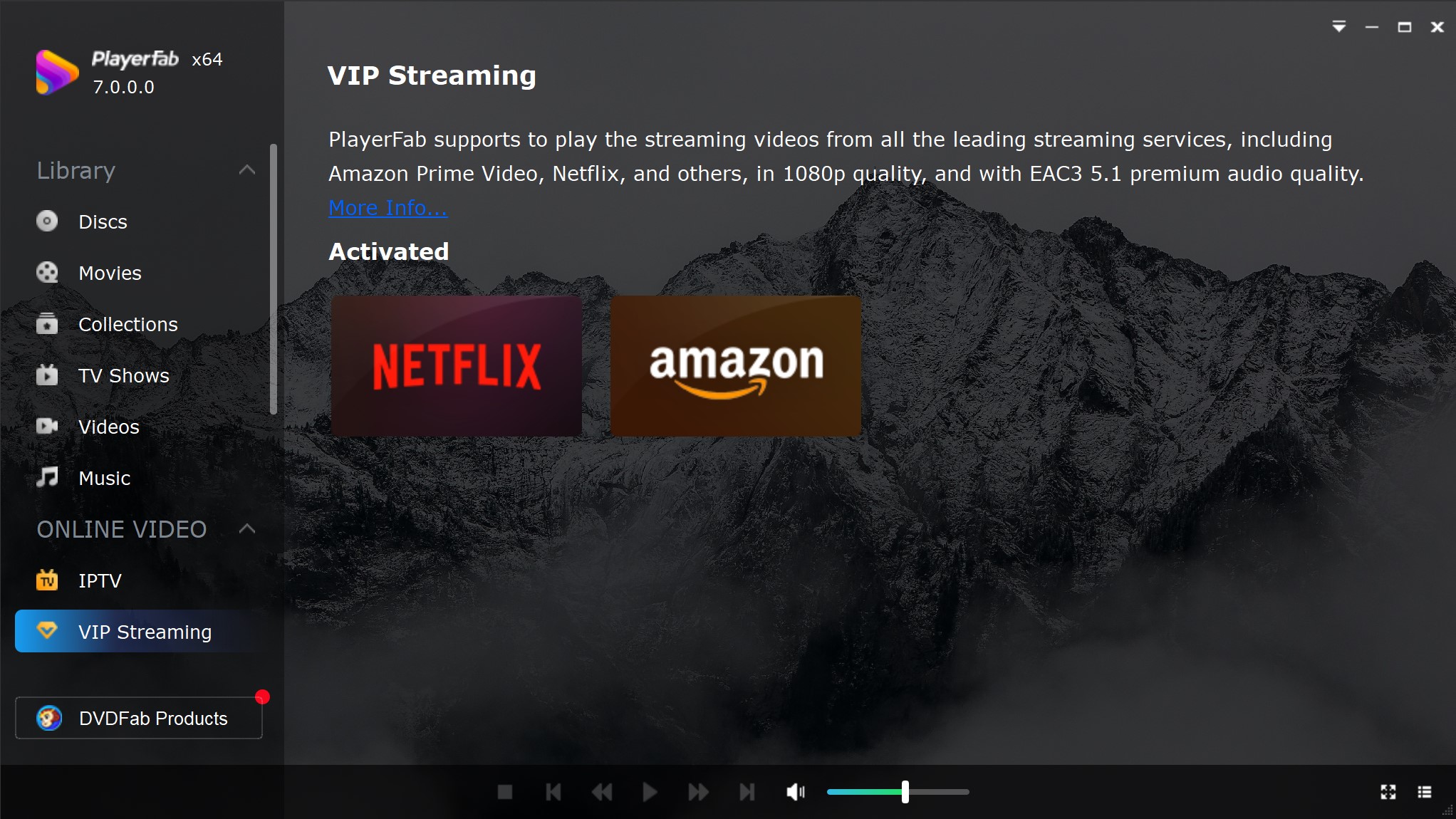

Les appareils qui prennent en charge ces formats HDR ont un coût. C'est pourquoi il n'est pas facile pour certains utilisateurs d'acheter des appareils aussi coûteux. Et si nous vous disions que vous pouvez regarder du contenu HDR sur vos appareils, qu'ils prennent ou non en charge le contenu HDR ? Oui ! C'est possible. Dans de tels cas, les utilisateurs peuvent utiliser le lecteur PlayerFab All-In-One. Le lecteur vous permet de regarder des formats HDR sur votre appareil, qu'il le supporte ou non. En outre, le lecteur prend également en charge la lecture des disques DVD/Blu-ray/UHD, des vidéos de Netflix et Amazon, ainsi que des vidéos locales. Jetez un coup d'œil à quelques-unes des fonctionnalités impressionnantes offertes par cet outil.

Fonctionnalités

- Le lecteur est capable de lire les formats HDR10, HDR10+ et Dolby Vision.

- Il permet de lire des vidéos en haute qualité audio et vidéo.

- Il peut lire des vidéos MOV locales ainsi que des vidéos dans différents formats autres que DVD/Blu-ray/UHD.

- Il permet aux utilisateurs de sélectionner les langues des sous-titres et de l'audio en fonction de leurs préférences.

- Il prend en charge les vidéos en streaming de Tubi, Netflix, Peacock, Amazon, et bien d'autres encore.

- Le lecteur permet de contrôler la vitesse de lecture

- Il peut sauter automatiquement l'intro lors de la lecture des vidéos.

- Il est doté d'une fonction de lecture automatique.

FAQs

Quelle est la quantité de mappage de tonalité offerte par le HDR10, le HDR10+ et le Dolby Vision ?

Tout d’abord, le mappage tonal offre des détails sur la façon dont un appareil peut afficher des couleurs qu’il n’affiche pas. En termes simples, si une vidéo HDR présente un rouge vif dans une scène, mais que l'appareil ne peut pas afficher cette nuance de rouge spécifique, que fait-il à la place ? Il existe deux méthodes permettant à un appareil de tonifier les couleurs de la carte afin de faire face à la situation. Le premier est appelé écrêtage, où un appareil devient si lumineux que vous ne voyez pas de différence au-dessus d'un niveau de luminosité spécifique, et il n'y a aucune couleur visible au-dessus de ce niveau.

L'autre méthode courante consiste à remapper la gamme de couleurs par l'appareil, ce qui signifie qu'il affiche les couleurs vives nécessaires sans écrêtage. Même si elle ne montre pas essentiellement la nuance de rouge nécessaire, au moins l'image apparaîtra toujours bonne. Il y a une diminution plus douce à mesure que les couleurs atteignent leur luminance la plus élevée. Par conséquent, les utilisateurs ne perdent aucun détail, mais les reflets généraux sont plus sombres que sur un téléviseur utilisant l'écrêtage.

Entre les trois normes HDR, les différences résident dans la manière dont chaque appareil gère le mappage tonal. Les formats dynamiques tels que HDR10+ et Dolby Vision peuvent mapper les tons image par image, et parfois la vidéo est mappée par les tons par la source. Cela permet d'économiser la puissance de traitement nécessaire à l'appareil. Comme la question demeure pour le HDR10 puisqu'il utilise des métadonnées statiques, le mappage de tons est le même sur toute la vidéo, donc le contenu ne semble pas aussi bon.

Conclusion

Les formats améliorés l'emportent clairement.

StreamFab All-In-One est un téléchargement de vidéos ultra 52-en-1 qui permet de télécharger des vidéos de Netflix, Disney+, YouTube et plus de 1000 sites Web populaires.